Sztuczna inteligencja to termin, który zyskał na znaczeniu w ostatnich latach, ale jego korzenie sięgają lat 50. XX wieku. To właśnie wtedy John McCarthy, amerykański informatyk, po raz pierwszy użył tego określenia podczas konferencji w Dartmouth. Jego prace i badania miały ogromny wpływ na rozwój technologii, które dziś nazywamy sztuczną inteligencją.

W artykule przyjrzymy się nie tylko Johnowi McCarthy'emu i jego osiągnięciom, ale także innym kluczowym postaciom, takim jak Alan Turing i Marvin Minsky. Zrozumienie początków sztucznej inteligencji jest istotne, ponieważ pozwala lepiej zrozumieć, jak te wczesne idee kształtują naszą współczesną technologię i jakie mogą mieć znaczenie w przyszłości. Najważniejsze informacje:- John McCarthy jest uważany za twórcę terminu "sztuczna inteligencja".

- McCarthy zorganizował konferencję w Dartmouth, która zapoczątkowała badania nad AI.

- Alan Turing, znany jako ojciec informatyki, wprowadził koncepcję testu Turinga, który ocenia zdolność maszyn do myślenia.

- Marvin Minsky był jednym z pionierów teorii sztucznej inteligencji, wprowadzając wiele innowacyjnych pomysłów.

- Ważne wydarzenia, takie jak wprowadzenie sieci neuronowych, miały kluczowy wpływ na rozwój AI.

- Zrozumienie historii AI jest kluczowe dla przewidywania przyszłych kierunków rozwoju technologii.

Kto wymyślił sztuczną inteligencję i jego znaczenie dla rozwoju

Sztuczna inteligencja (AI) to termin, który zyskał na znaczeniu w ostatnich latach, ale jego początki sięgają lat 50. XX wieku. To właśnie wtedy John McCarthy, amerykański informatyk, po raz pierwszy użył tego określenia podczas konferencji w Dartmouth. Jego prace w tej dziedzinie miały ogromny wpływ na rozwój technologii, które dziś nazywamy sztuczną inteligencją. McCarthy nie tylko zdefiniował pojęcie, ale również zapoczątkował badania nad AI, które zmieniły sposób, w jaki postrzegamy maszyny i ich zdolności.

Wprowadzenie terminu "sztuczna inteligencja" miało kluczowe znaczenie dla rozwoju tej dziedziny. Umożliwiło to naukowcom i inżynierom skupienie się na badaniach, które dotyczyły zarówno teorii, jak i praktycznych zastosowań AI. W rezultacie powstały nowe technologie oraz metody, które są fundamentem współczesnych systemów inteligentnych. Dlatego zrozumienie, kto wymyślił sztuczną inteligencję, jest nie tylko interesujące, ale także istotne dla przyszłości tej dziedziny.John McCarthy: pionier sztucznej inteligencji i jego osiągnięcia

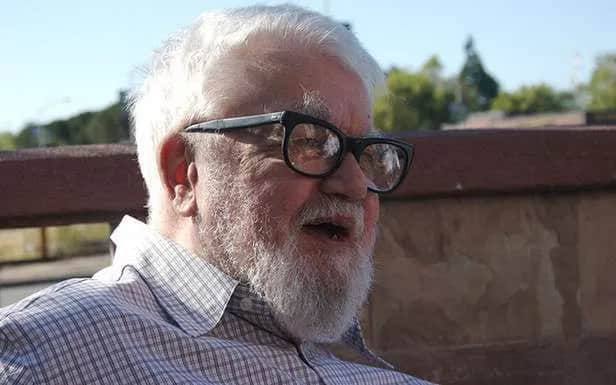

John McCarthy był kluczową postacią w historii sztucznej inteligencji. W 1956 roku zorganizował konferencję w Dartmouth, która uznawana jest za początek badań nad AI. Na tym wydarzeniu spotkali się naukowcy z różnych dziedzin, aby omówić możliwości tworzenia maszyn, które potrafiłyby myśleć i uczyć się. McCarthy był również twórcą języka programowania LISP, który stał się podstawowym narzędziem w badaniach nad AI.

W ciągu swojej kariery McCarthy opracował wiele koncepcji, które miały wpływ na rozwój sztucznej inteligencji. Jego prace nad reprezentacją wiedzy oraz rozumowaniem w AI otworzyły nowe horyzonty dla naukowców. McCarthy był także jednym z pierwszych, którzy zauważyli znaczenie interakcji między ludźmi a maszynami, co miało kluczowe znaczenie dla dalszego rozwoju technologii.

Warto również wspomnieć, że McCarthy był jednym z założycieli AI Lab na Massachusetts Institute of Technology (MIT), gdzie prowadził badania nad sztuczną inteligencją przez wiele lat. Jego wkład w rozwój tej dziedziny jest nieoceniony, a jego idee wciąż inspirują współczesnych badaczy i inżynierów.

Jak termin "sztuczna inteligencja" wpłynął na naukę i technologię

Termin "sztuczna inteligencja" miał ogromny wpływ na rozwój nauki i technologii. Jego wprowadzenie umożliwiło naukowcom skupienie się na badaniach, które dotyczyły nie tylko teorii, ale także praktycznych zastosowań. Dzięki temu powstały nowe metody i technologie, które zrewolucjonizowały wiele dziedzin, w tym medycynę, inżynierię i edukację.

W miarę jak sztuczna inteligencja się rozwijała, zaczęła wkraczać w różne aspekty życia codziennego. Zastosowania AI w takich dziedzinach jak analiza danych, rozpoznawanie obrazów czy przetwarzanie języka naturalnego stały się powszechne. Interdyscyplinarne podejście do badań nad AI pozwoliło na połączenie wiedzy z różnych dziedzin, co przyczyniło się do szybszego rozwoju technologii i innowacji.Kluczowe postacie w historii sztucznej inteligencji

W historii sztucznej inteligencji (AI) wiele osób odegrało kluczowe role, które przyczyniły się do rozwoju tej fascynującej dziedziny. Oprócz John McCarthy'ego, który wymyślił termin "sztuczna inteligencja", inni naukowcy i badacze wnieśli istotny wkład w rozwój teorii oraz technologii AI. Ich osiągnięcia pomogły w kształtowaniu kierunków badań oraz zastosowań sztucznej inteligencji, co miało ogromny wpływ na współczesną technologię.

Alan Turing: ojciec informatyki i jego wpływ na AI

Alan Turing, znany jako ojciec informatyki, miał ogromny wpływ na rozwój sztucznej inteligencji. Jego prace z lat 30. i 40. XX wieku stworzyły fundamenty dla nowoczesnych komputerów. Turing wprowadził pojęcie maszyny uniwersalnej, która mogła wykonywać różne obliczenia, a jego badania nad algorytmami przyczyniły się do rozwoju programowania. Jednym z jego najważniejszych osiągnięć jest test Turinga, który ocenia zdolność maszyn do myślenia i interakcji z ludźmi.

Test Turinga polega na tym, że jeśli maszyna potrafi prowadzić rozmowę z człowiekiem w taki sposób, że ten nie jest w stanie stwierdzić, czy rozmawia z maszyną, czy z inną osobą, to uznaje się ją za inteligentną. Turing wprowadził również koncepcję "inteligencji maszynowej", co stało się kluczowym punktem odniesienia dla dalszych badań w dziedzinie AI. Jego prace zainspirowały wielu naukowców do eksploracji możliwości tworzenia inteligentnych systemów.

Marvin Minsky: wkład w rozwój teorii sztucznej inteligencji

Marvin Minsky był jednym z pionierów sztucznej inteligencji, który znacząco wpłynął na rozwój tej dziedziny. Współzałożyciel MIT AI Lab, Minsky prowadził badania nad różnymi aspektami AI, w tym nad rozumieniem i reprezentacją wiedzy. Jego książka "The Society of Mind" z 1986 roku wprowadza koncepcję, że inteligencja jest wynikiem współdziałania wielu prostszych jednostek, co miało ogromny wpływ na rozwój teorii AI.

Minsky był również zaangażowany w rozwój technologii robotycznych oraz w badania nad percepcją i uczeniem maszynowym. Jego prace przyczyniły się do stworzenia algorytmów, które pozwalają maszynom uczyć się na podstawie doświadczenia. Minsky był zwolennikiem interdyscyplinarnego podejścia do badań nad AI, co zaowocowało wieloma innowacyjnymi pomysłami i projektami, które wciąż inspirują współczesnych badaczy.

Milestones w rozwoju sztucznej inteligencji

Rozwój sztucznej inteligencji (AI) był na przestrzeni lat pełen kluczowych wydarzeń i przełomowych technologii, które znacząco wpłynęły na jej ewolucję. Te milestones w historii AI nie tylko kształtowały kierunki badań, ale także umożliwiły wprowadzenie innowacyjnych rozwiązań, które zmieniły nasze podejście do technologii. Zrozumienie tych kamieni milowych jest istotne, ponieważ pozwala na lepsze przewidywanie przyszłych kierunków rozwoju AI oraz jej zastosowań w różnych dziedzinach życia.

- 1956 - Konferencja w Dartmouth, gdzie po raz pierwszy użyto terminu "sztuczna inteligencja".

- 1966 - Rozpoczęcie prac nad programem ELIZA, jednym z pierwszych systemów przetwarzania języka naturalnego.

- 1980 - Powstanie systemów ekspertowych, które zaczęły być wykorzystywane w różnych branżach, takich jak medycyna i inżynieria.

- 1997 - Komputer IBM Deep Blue pokonuje mistrza świata w szachach Garry'ego Kasparowa.

- 2012 - Wprowadzenie głębokiego uczenia (deep learning) w rozpoznawaniu obrazów, co zrewolucjonizowało AI.

Ważne wydarzenia, które kształtowały AI na przestrzeni lat

Jednym z najważniejszych wydarzeń w historii sztucznej inteligencji była konferencja w Dartmouth w 1956 roku, gdzie po raz pierwszy formalnie wprowadzono pojęcie sztucznej inteligencji. To wydarzenie zgromadziło czołowych naukowców, którzy zaczęli badać możliwości tworzenia maszyn zdolnych do myślenia i uczenia się. W kolejnych latach, w miarę rozwoju technologii komputerowej, pojawiały się nowe koncepcje i metody, które przyczyniły się do postępu w dziedzinie AI.

W 1966 roku powstał program ELIZA, który stał się jednym z pierwszych przykładów systemu przetwarzania języka naturalnego. ELIZA potrafiła prowadzić proste rozmowy z użytkownikami, co otworzyło drzwi do dalszych badań nad interakcją człowiek-maszyna. Kolejnym przełomowym momentem był rok 1997, kiedy komputer IBM Deep Blue pokonał mistrza świata w szachach Garry'ego Kasparowa. To wydarzenie pokazało, jak daleko zaszły możliwości komputerów w dziedzinie strategii i analizy.

Przełomowe technologie, które zmieniły oblicze sztucznej inteligencji

W miarę jak sztuczna inteligencja się rozwijała, wprowadzano nowe technologie, które miały kluczowy wpływ na jej ewolucję. Jednym z najważniejszych osiągnięć było wprowadzenie głębokiego uczenia (deep learning), które zrewolucjonizowało sposób, w jaki komputery przetwarzają dane. Dzięki zastosowaniu sieci neuronowych, maszyny zaczęły lepiej rozumieć obrazy, dźwięki i teksty, co pozwoliło na rozwój zaawansowanych systemów rozpoznawania obrazów i przetwarzania języka naturalnego.

Inne przełomowe technologie, takie jak uczenie maszynowe (machine learning), również miały znaczący wpływ na rozwój AI. Umożliwiły one komputerom analizowanie ogromnych zbiorów danych, co prowadziło do lepszych prognoz i decyzji opartych na danych. Wprowadzenie technologii takich jak sieci neuronowe i algorytmy genetyczne przyczyniło się do dalszego rozwoju AI, tworząc nowe możliwości w różnych dziedzinach, od medycyny po przemysł.

| Technologia | Opis |

| Głębokie uczenie | Technika oparta na sieciach neuronowych, która umożliwia komputerom rozpoznawanie wzorców w dużych zbiorach danych. |

| Uczenie maszynowe | Metoda, która pozwala komputerom na uczenie się na podstawie danych, bez konieczności programowania konkretnych reguł. |

| Sieci neuronowe | Modele inspirowane ludzkim mózgiem, które są używane do przetwarzania informacji i rozwiązywania problemów. |

Dlaczego zrozumienie początków AI jest istotne dla przyszłości

Zrozumienie początków sztucznej inteligencji (AI) jest kluczowe dla dalszego rozwoju tej dziedziny. Historia AI dostarcza cennych lekcji na temat tego, jak technologia ewoluowała i jakie wyzwania były napotykane na różnych etapach rozwoju. Analizując przeszłość, możemy lepiej przewidywać przyszłe kierunki badań i zastosowań AI, a także unikać błędów, które zostały popełnione w przeszłości.

W miarę jak sztuczna inteligencja staje się coraz bardziej integralną częścią naszego życia, ważne jest, aby zrozumieć, jak jej początki wpłynęły na aktualne praktyki. Refleksja nad historią AI pozwala na lepsze zrozumienie jej potencjału oraz ograniczeń, co jest niezbędne do kształtowania odpowiedzialnych i etycznych rozwiązań w przyszłości.

Jak historia sztucznej inteligencji wpływa na jej rozwój dziś

Historia sztucznej inteligencji dostarcza fundamentów dla współczesnych badań i praktyk. Wiele koncepcji i technologii, które były rozwijane w przeszłości, wciąż mają zastosowanie w dzisiejszych systemach AI. Na przykład, algorytmy uczenia maszynowego, które były badane od lat 80., są teraz podstawą wielu nowoczesnych aplikacji, takich jak rozpoznawanie obrazów czy przetwarzanie języka naturalnego.

Współczesne wyzwania w dziedzinie sztucznej inteligencji, takie jak etyka AI czy bezpieczeństwo danych, również mają swoje korzenie w przeszłości. Zrozumienie, jak te kwestie były traktowane w historii, może pomóc w opracowywaniu bardziej skutecznych rozwiązań. W ten sposób historia AI nie tylko informuje nas o tym, co było, ale także wskazuje drogę do przyszłości, w której technologia może być wykorzystywana w sposób odpowiedzialny i korzystny dla społeczeństwa.

Wnioski na temat przyszłości AI oparte na przeszłości

Analizując historię sztucznej inteligencji, możemy wyciągnąć cenne wnioski, które mogą prowadzić do dalszego rozwoju tej dziedziny. Po pierwsze, zrozumienie przeszłych błędów i sukcesów pozwala na unikanie powielania tych samych problemów w przyszłości. Na przykład, wcześniejsze podejścia do AI, które nie uwzględniały etyki i bezpieczeństwa, mogą służyć jako przestroga dla współczesnych badaczy i inżynierów. Warto zatem, aby przyszłe projekty i badania były prowadzone z uwzględnieniem tych nauk.

Po drugie, kluczowe jest, aby uczyć się na podstawie doświadczeń z przeszłości. Wiele innowacji, które zrewolucjonizowały sztuczną inteligencję, opierało się na wcześniejszych teoriach i technologiach. Dlatego ważne jest, aby kontynuować badania nad już istniejącymi koncepcjami, a także eksplorować nowe kierunki. W miarę jak AI staje się coraz bardziej złożona, przyszłość tej dziedziny będzie wymagała zarówno kreatywności, jak i solidnych podstaw teoretycznych, które zostały zbudowane na doświadczeniach z przeszłości.

Jak sztuczna inteligencja zmienia nasze codzienne życie i pracę

Sztuczna inteligencja (AI) nie tylko ewoluuje w kontekście technologii, ale także ma znaczący wpływ na nasze codzienne życie oraz sposób, w jaki pracujemy. Przykładem tego są inteligentne asystenty, takie jak Siri czy Google Assistant, które wykorzystują AI do ułatwienia codziennych zadań. Dzięki nim możemy zarządzać naszym czasem, organizować spotkania czy uzyskiwać informacje w czasie rzeczywistym, co zwiększa naszą efektywność i komfort życia.

W kontekście pracy, automatyzacja procesów staje się coraz bardziej powszechna. Firmy wykorzystują AI do analizy danych, co pozwala na szybsze podejmowanie decyzji i optymalizację działań. Na przykład, w branży marketingowej, AI może analizować zachowania konsumentów, co umożliwia tworzenie spersonalizowanych kampanii reklamowych. W przyszłości możemy spodziewać się jeszcze szerszego zastosowania AI w różnych dziedzinach, co może prowadzić do dalszej transformacji sposobu, w jaki pracujemy i żyjemy.